DES-Projekt Hochschulschriften: XXX. Jahrgang in der Erfassung mit noch mehr KI-Unterstützung

Über das seit Dezember 2021 laufende DES-Projekt „Hochschulschriften“ des Vereins für Computergenealogie in Zusammenarbeit mit dem Max-Planck-Institut für Innovation und Wettbewerb in München berichtet der CompGen-Blog regelmäßig. Mit dem neuen Jahrgang für 1914 wurde die Vorbereitung der Einträge mit Hilfe von Großen Sprachmodellen weiter verbessert.

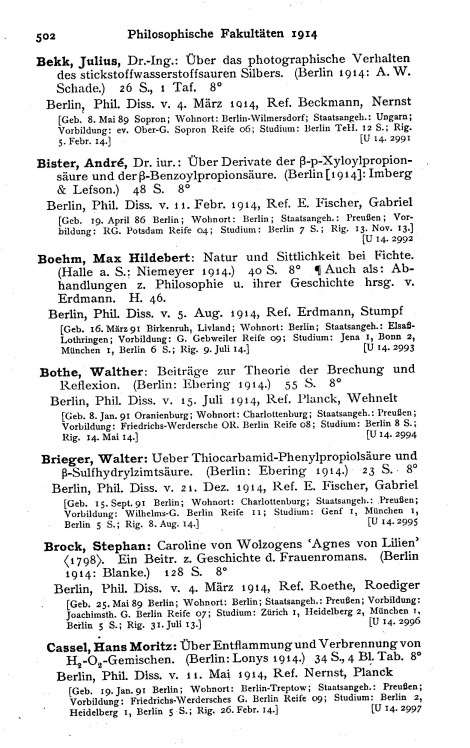

Seit der letzten Meldung wurden die Jahrgänge 1912 und 1913 abgeschlossen. Die Datenbank umfasst nun knapp 84.000 vollständig korrigierte Einträge. Jüngst wurde der XXX. Jahrgang für das Jahr 1914 zur Korrektur in die Datenbank eingespeist. Er ist mit 4.833 Einträgen minimal größer als der vorherige Jahrgang.

Der neue Jahrgang ist schon deshalb besonders, weil er die erste Generation von Doktoranden umfasst, die während des Ersten Weltkriegs promoviert wurden; seine Bearbeitung ist aber auch deshalb bemerkenswert, weil bei der Vorbereitung in noch stärkerem Maße als bisher auf Künstliche Intelligenz (KI) gesetzt wird.

Die KI unterstützt noch mehr

Bisher sah die Vorbereitung der Einträge so aus: Nach dem Scannen übernimmt Transkribus die Aufgabe, mit seinem KI-Modell die Texte automatisch zu erkennen. Die resultierenden Textblöcke werden anschließend von einem eigens entwickelten Computer-Programm in einzelne Felder zerlegt: Wo endet der Name, wo beginnt der Titel, was gehört zum biographischen Block? Das geschieht mit einfachen Regeln, beispielsweise basierend auf Satzzeichen. Diese Regeln sind einfach und helfen im Großen und Ganzen, aber bei Spezialfällen versagen sie. Zudem waren sie wartungsintensiv, da Änderungen im Format fortlaufend Anpassungen notwendig machten. Ein weiterer Nachteil: Wenn Transkribus ein Zeichen nicht erkannt hatte, konnte unser Programm diesen Fehler nicht ausbügeln.

Genau diesen zweiten Verarbeitungsschritt übernimmt nun eine KI. Zum Einsatz kommt das offene Große Sprachmodell („Large Language Model”, LLM) GPT OSS120B. Wie GPT-4, welches z.B. in ChatGPT verwendet wird, gehört es zur US-amerikanischen Softwareschmiede OpenAI. Auch andere Modelle wurden getestet. Die besten Ergebnisse lieferte jedoch GPT OSS 120B.

Die Anweisungen für das Modell (der sogenannte „Prompt”) umfassen über 1.500 Wörter. Nach allgemeiner Aufgabenstellung folgt dann für jedes der 28 Felder eine detaillierte Erklärung, was hier zu erwarten ist. Anschließend folgt eine Liste der Dinge, die das Modell machen darf. Ziel ist immer noch, sehr konservativ zu arbeiten und nicht zu halluzinieren.

Weniger Arbeit und mehr Zufriedenheit

Die Unterstützung durch das Große Sprachmodell wird gut angenommen. Zwar mussten die Ergebnisse kurz nachjustiert werden, was mithilfe der Online-Schnittstelle von DES schnell gelang. Doch die freiwilligen Erfasser sind zufrieden. Einer von ihnen schrieb „… die Korrektur [geht] mindestens doppelt so schnell wie vorher.”

Wer auch bei diesem innovativen Projekt mitmachen möchte, kann sich hier im GenWiki informieren.